Servicios Personalizados

Revista

Articulo

Links relacionados

Compartir

Páginas de Educación

versión On-line ISSN 1688-7468

Pág. Educ. vol.7 no.1 Montevideo mayo 2014

FACTORES EXPLICATIVOS DE LA EFICIENCIA EDUCATIVA EN URUGUAY: EVIDENCIA A PARTIR DE PISA 2012

Educational Efficiency Drivers in Uruguay: Evidence from PISA 2012

Gabriela Sicilia1

Resumen. El enorme esfuerzo presupuestario observado en Uruguay en la última década no ha sido acompañado de mejoras en los resultados académicos, lo cual evidencia la posible presencia de ineficiencias en el sistema educativo. En este sentido, el objetivo de este artículo es identificar los factores determinantes de la eficiencia educativa en los centros públicos de educación secundaria. En base a la información de PISA 2012, las estimaciones revelan que sería posible mejorar los resultados académicos en un 7,4% en promedio dado los recursos actuales. Para ello, las políticas educativas deberían focalizarse en revisar las políticas de repetición vigentes, las prácticas de instrucción docente y la gestión de los docentes en los centros, así como trabajar sobre el grado de estrés de los estudiantes asociado al trabajo con las matemáticas.

Palabras claves: Educación secundaria, Eficiencia técnica, PISA, DEA.

Abstract. The significant budgetary effort observed in Uruguay in the last decade has not been accompanied by better academic results, which evidences the possible presence of inefficiencies in the education system. In this sense, the aim of this paper is to identify the main potential sources of educational efficiency in secondary public schools. Based on information from PISA 2012, the analysis reveals that there is potential for these schools to improve their academic outcomes by on average 7.4% with the current resource allocation. To achieve this, educational policies should primarily focus on reviewing the existing repetition policies, teacher’s instructional practices and management of teachers in schools as well as working on reducing the students’ stress level associated with their work on maths.

Key words: Secondary schools, Technical efficiency, PISA, DEA.

Recibido el 5 de agosto de 2014

Aceptado el 27 de agosto de 2014

Introducción

El creciente interés por el estudio de la calidad de la enseñanza responde básicamente a dos hechos: por un lado el demostrado impacto positivo que tienen los resultados académicos sobre las tasas de crecimiento y desarrollo económico de los países (Barro y Lee; Hanushek y Woessmann) y, por otra parte, el hecho de que la educación es uno de principales rubros de gasto público en la mayoría de los países del mundo.

En efecto, el Sector Público es el principal proveedor de la educación secundaria en Uruguay donde, en 2012, el 84% de los estudiantes asistían a centros públicos (ANEP). En este sentido, el nivel de gasto en educación que realiza un gobierno y el porcentaje que Éste representa en términos de PIB, son los indicadores más utilizados para medir la inversión que realiza un país en educación. En Uruguay, el gasto público en educación representaba, en 2000, un 3,53% del PIB, mientras que una década más adelante ascendía a 4,5%.2 Sin embargo, este enorme esfuerzo en materia presupuestaria no ha sido acompañado de reformas y políticas educativas adecuadas que conlleven a mejores resultados educativos. En efecto, en los últimos años se observa un estancamiento y crisis del sistema educativo, en particular en la enseñanza secundaria, donde existen elevadas tasas de repetición y bajas tasas de egreso del sistema, así como un deterioro sostenido en los resultados académicos. Por ejemplo, la tasa de repetición de 1º a 4º año de secundaria se ha incrementado entre 2003 y 2012 de 21,3% a 27% mientras que la tasa de promoción se ha reducido de 72,7% a 67,4% en igual período (ANEP). Si bien es cierto que durante esta misma década las tasas netas de asistencia de la educación secundaria han aumentado, el número de alumnos matriculados en el sistema se ha mantenido estable. Es decir, la mayor tasa neta de asistencia responde a un menor número de jóvenes de entre 12 y 17 años y no a un incremento absoluto en el número de estudiantes matriculados. Asimismo, según evidencian los Informes PISA (Programme for International Student Assessment) llevados a cabo por la OCDE (Organización para la Cooperación y el Desarrollo Económico), los resultados académicos se han mantenido estancados en las tres primeras oleadas en las que Uruguay ha participado con una tendencia a la baja en el último ciclo. En 2003, Uruguay obtuvo un promedio en las tres disciplinas evaluadas de 428 puntos, el cual se ha mantenido relativamente estable durante 2006 y 2009 (423 y 426 respectivamente), mientras que en 2012 el resultado medio desciende a 412 puntos.

Como consecuencia de este panorama, los problemas del sistema educativo uruguayo son una preocupación recurrente, no sólo para las autoridades responsables del diseño de las políticas educativas y el gobierno sino también para los profesores y las familias involucrados en el proceso de enseñanza. Sin embargo, lamentablemente, el debate nacional eduactivo se ha centrado principalmente en la asignación de recursos presupuestarios al sistema. Sin embargo, no hay evidencia empírica sistemática en la literatura de economía de la educación que demuestre que un mayor nivel de recursos per se conduce directamente a mejores resultados (Hanushek 2003).

Estos resultados ponen de manifiesto la necesidad de evaluar el sistema educativo actual de Uruguay desde una perspectiva basada no sólo en los resultados educativos sino en analizar la existencia de comportamientos ineficientes de las unidades en el proceso productivo y en explicar dichas ineficiencias a través de variables asociadas al alumno y al centro educativo. La importancia de este tipo de estudios radica en el hecho de que la presencia de ineficiencias en un sistema educativo implicaría que no se está sacando el mayor provecho de los recursos educativos y que, por tanto, es posible incrementar los resultados académicos con los recursos ya disponibles en el sistema, lo cual resulta ser una de las principales ambiciones de las autoridades actuales.

Existen numerosos estudios a nivel internacional que aplican modelos semi-paramétricos de dos etapas en materia educativa para explicar la eficiencia de los centros educativos: Abraham Charnes et al. (1997); Shawna Grosskopf et al.; Mei Xue y Patrick Harker; María Jesús Mancebón y C. Mar Molinero; Antonio Afonso y Miguel Aubyn; Ayoe Hoff; Leopold Simar y Paul Wilson; José Manuel Cordero et al. (2008; 2010); Robert Alexander et al. (2010); Jorge De Justo y Daniel Santín.3. Sin embargo, en el contexto latinoamericano, son escasas las investigaciones disponibles y, en particular, para el caso uruguayo hasta el momento no se conocen estudios sobre el tema.

En suma, el presente artículo se centra en explorar las fuentes de las ineficiencias en los centros de enseñanza secundaria pública con el fin de aportar nuevos elementos para el debate acerca de cómo fortalecer el sistema educativo actual y mejorar los resultados académicos de los estudiantes. Con este propósito, utilizando datos del programa PISA 2012, se aplica un modelo semi-paramétrico en dos etapas donde, en una primera etapa, se estima una frontera productiva mediante un modelo DEA, la cual define un nivel de eficiencia educativa para cada centro. Posteriormente, en una segunda etapa, se explican los comportamientos ineficientes utilizando diversos modelos de regresión alternativos aplicando el procedimiento bootstrap propuesto por Leopold Simar y Paul Wilson y se comparan los resultados.

El artículo se organiza de la siguiente forma. En la sección siguiente se expone la metodología utilizada. En la tercera, se describe brevemente el programa PISA y se presentan las variables seleccionadas en el análisis. La cuarta sección está dedicada a la discusión de los resultados. Por último, se exhiben las principales conclusiones del artículo y las implicaciones que éstas podrían tener en materia de política educativa.

METODOLOGÍA

El concepto de función de producción educativa hace referencia a la relación que existe entre resultados y recursos educativos, dada una tecnología productiva. El enfoque teórico utilizado en el presente artículo que relaciona los recursos con los resultados educativos a nivel de centro educativo está basado en la función de producción educativa propuesta por Hanrey Levin, y Eric Hanushek (1979):

Ecuación 1

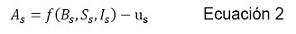

donde los subíndices s refieren al centro educativo respectivamente, y representa el vector de outputs educativos del centro. Por otra parte, los inputs educativos (factores imprescindibles para desarrollar la actividad educativa), se dividen en cuatro grupos: (características socioeconómicas del hogar del que provienen los alumnos), (recursos educativos del centro) y por último, (capacidad innata de los alumnos y su esfuerzo).

La estimación de dicha función de producción educativa es llevada a cabo frecuentemente considerando la posible existencia de comportamientos ineficientes en los centros. En este caso, se estimaría una frontera productiva donde los centros plenamente eficientes aprovecharían al máximo sus recursos y estarían sobre la frontera y, por tanto, la medida de ineficiencia sería la distancia de cada centro a la frontera construida. La ineficiencia se asocia a diversos factores: incorrecta organización y/o gestión de los centros, inadecuadas prácticas educativas que tienen lugar en el aula, métodos de evaluación inapropiados, escasa motivación e incentivos de profesores y/o alumnos, etc. Por tanto, la función de producción a estimar sería:

Ecuación 2

donde representa el nivel de eficiencia. Valores nulos de suponen que las unidades analizadas son plenamente eficientes, es decir, dado su nivel de inputs educativos y, dada la tecnología existente, estos centros están maximizando y gestionando correctamente el nivel de outputs que obtienen. Valores positivos de señalarían que el centro es ineficiente y por tanto la cuantía de la ineficiencia indica la cantidad de output que podría ser aumentado si se eliminara la ineficiencia.

En resumen, tres tipos de variables están involucradas en el proceso de producción: outputs educativos (), inputs educativos (, ) y el nivel de eficiencia estimada () para cada centro educativo. Subhash Ray, y Therese McCarty y Suthathip Yaisawarng fueron los primeros en proponer la aplicación de un modelo de dos etapas semiparamétrico para estimar los índices de eficiencia e identificar los principales factores explicativos de las ineficiencias. La primera etapa de este enfoque consiste en aplicar un modelo Análisis Envolvente de Datos (DEA) para estimar la eficiencia técnica, mientras que en la segunda etapa se regresan dichos índices sobre variables explicativas relacionadas a los alumnos y al centro educativo. A continuación se presenta una descripción más detallada de la metodología de dos etapas.

El modelo Análisis Envolvente de Datos (DEA)

La medición de la eficiencia se asocia con el concepto farreliano de eficiencia técnica. Michael Farrel define la frontera de producción como el nivel máximo de output que una unidad tomadora de decisiones (DMU) puede alcanzar dado el nivel de inputs y la tecnología disponibles (orientación al output).4 En la práctica, la verdadera frontera de producción y la tecnología no son conocidos y deben ser estimados a partir de las mejores prácticas observadas en la muestra.

Básicamente, hay dos grupos principales de técnicas de estimación de la frontera de producción: el enfoque paramétrico o enfoques econométricos (véase Battese y Coelli 1988, 1992, 1995), y los métodos no paramétricos basados en modelos matemáticos de optimización. Aunque el uso de los enfoques paramétricos se ha incrementado en la medición de la eficiencia educativa en las últimas décadas, los enfoques no paramétricos han sido los métodos aplicados más ampliamente (Worthington).

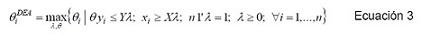

Desde los trabajos pioneros de Abraham Charnes, William W. Cooper y Edward Rhodes (1978, 1981) y Rajiv D. Banker, Abraham Charnes y William W. Cooper, el modelo DEA ha sido ampliamente utilizado para medir la eficiencia en diversas áreas del gasto público.5 La razón principal para su aplicación generalizada es su gran flexibilidad fundalmentalmente al carácter multidimensional del output, a la falta de conocimiento de la tecnología de producción y de información acerca de los precios de las variables que permite adaptarse a las peculiaridades del sector público. La técnica consiste en aplicar un programa de optimización lineal para obtener una frontera de producción que incluye todas las unidades eficientes y sus posibles combinaciones lineales. Como resultado, el índice de eficiencia estimado para cada DMU es una medida relativa estimada usando todas las unidades de producción. La formulación del programa DEA orientado al output con rendimientos variables a escala (modelo DEA-BBC) para cada unidad analizada se define como:

Ecuación 3

donde, para la i-ésima unidad: es el índice de eficiencia, es el vector de outputs y es el vector de inputs. Y por tanto, X y Y son las respectivas matrices de inputs y outputs . El vector de dimensión ( contiene las ponderaciones virtuales de cada unidad determinadas por la solución del problema. Si definimos , representa la distancia que existe entre la i-ésima unidad y la frontera productiva. Si la unidad es eficiente mientras que para valores mayores a la unidad la unidad es ineficiente. A mayor valor de , mayor es la distancia a la frontera productiva y, por lo tanto, mayor ineficiencia. Así por ejemplo, un índice de eficiencia igual a 1,1 implica que la unidad podría mejorar sus resultados en un 10% si fuera eficiente.

Modelos de segunda etapa

Una vez estimados los índices de eficiencia, en una segunda etapa éstos se regresan sobre un vector de variables contextuales asociadas a los centros y a los alumnos, las cuales no están directamente relacionadas con la producción educativa pero sí pueden influir sobre la eficiencia:

Ecuación 4

El método de estimación más utilizado en la literatura en esta segunda etapa ha sido el modelo de regresión censurada y en algunos casos mínimos cuadrados ordinarios (MCO); del cual puede extraerse cuáles son los factores que explican los índices de eficiencia:

Ecuación 5

Mei Xue y Patrick Harker fueron los primeros en argumentar que estos modelos de regresión convencionales aplicados en la segunda etapa resultan sesgados dado que los índices de eficiencia estimados en la primera etapa están correlacionados entre sí. En consecuencia, en los últimos años ha habido un debate intenso acerca de cuál sería el modelo más adecuado para aplicar en esta segunda etapa con el fin de proporcionar estimaciones consistentes. Según Leopold Simar y Paul Wilson, los índices de eficiencia estimados por el modelo DEA en la primera etapa están correlacionados por construcción (ya que son medidas relativas) y por lo tanto las estimaciones de los métodos de regresión convencionales (Ecuación 5) estarían sesgados. Adicionalmente, otra posible fuente de sesgo en las estimaciones podría ser la existencia de correlación entre las variables contextuales Zi y el término de error en la Ecuación 5.

Simar y Wilson proponen aplicar bootstrapping para superar dichos inconvenientes. En su artículo, los autores proponen dos algoritmos que incorporan el procedimiento de bootstrap a un modelo de regresión truncada. Mediante un experimento de Monte Carlo los autores examinan y comparan la performance de estos dos algoritmos y demuestran que ambos superan a los métodos de regresión convencionales (Tobit y regresiones truncadas sin bootstrap). Para muestras pequeñas (problemas con menos de 400 unidades y hasta tres outputs y tres inputs), el Algoritmo # 1 propuesto se ajusta mejor que el Algoritmo # 2, que es más eficiente a partir de muestras que exceden las 800 unidades. Dado que la muestra analizada en nuestro artículo es menor a 400, aplicamos el Algoritmo # 1, que se describe a continuación:

1. Estimar los índices de eficiencia resolviendo el modelo DEA (Ecuación 3).

2. Estimar mediante el método de máxima verosimilitud en una regresión truncada de sobre zi (Ecuación 5), utilizando las observaciones donde

3. Iterar los pasos (3.a - 3.c) veces mediante un bucle, obteniendo las estimaciones bootstrap de.

a. Para cada extraer de una distribución normal truncada a la izquierda en .

b. Nuevamente, para estimar .

c. Utilizando máxima verosimilitud estimar la regresión truncada de sobre, obteniendo las estimaciones.

4) Usar los L valores de A para construir los intervalos de confianza de b y se.

Posteriormente Ayoe Hoff, John McDonald, y Rajiv Banker y Ram Natarajan retoman la discusión acerca de la utilización de modelos MCO y Tobit en la segunda etapa. A diferencia de Hoff, el cual concluye que tanto el modelo Tobit como el modelo MCO generan estimaciones consistentes, McDonald demuestra que sólo el primero arroja resultados consistentes. Simar y Wilson vuelven a participar en el debate en curso y concluyen que sólo la regresión truncada y, bajo supuestos muy particulares y excepcionales, el modelo MCO también proporciona estimaciones consistentes. Además, demuestran que en ambos casos sólo los métodos que incorporan bootstrap proporcionan inferencia estadística válida.

A la vista de lo expuesto anteriormente, se concluye que no existe consenso en la comunidad científica sobre cual(es) modelo(s) de regresión proporciona(n) estimaciones más consistente, ya que esta conclusión depende de los supuestos previos acerca del proceso generador de datos. Por esta razón, en el presente artículo se ha optado por adoptar como base en la segunda etapa el Algoritmo #1 propuesto por Simar y Wilson y, adicionalmente, estimar dos modelos alternativos con el fin de comparar la robustez de los resultados: un modelo Tobit y un modelo MCO incorporando bootstrap.

DATOS Y VARIABLES

A continuación se describe brevemente la base de datos PISA 2012 y se presentan las variables seleccionadas en cada una de las etapas para llevar a cabo el análisis.

La base de datos PISA

Para llevar a cabo el presente artículo se seleccionó la base de datos del Informe PISA 2012 por motivos de disponibilidad de información. Hasta el momento, PISA es la única fuente de datos disponible para Uruguay que proporciona información oportuna acerca del resultado académico de los alumnos de educación secundaria medido a través de pruebas objetivas comparables y que, a su vez, proporciona información acerca de las familias de los estudiantes y del centro educativo. Asimismo, la publicación de los datos PISA 2012 es muy reciente, lo cual permite obtener resultados oportunos para el debate educativo actual.

El proyecto PISA 2012 corresponde a la quinta edición de una iniciativa impulsada por la OCDE a finales de los años noventa, con el objetivo de evaluar a estudiantes de 15 años de edad. La evaluación se centra en tres ámbitos: comprensión lectora (lectura), matemáticas y ciencias focalizándose en 2012 en matemáticas. La evaluación no se basa en los contenidos curriculares sino que, para hacer los resultados comparables internacionalmente, se centra en medir el dominio que tiene el alumno de ciertos procesos, la comprensión de conceptos y la capacidad para desenvolverse ante distintos problemas.

Adicionalmente a los resultados académicos, la base de datos PISA contiene un enorme volumen de información acerca del alumno, del hogar y de los centros educativos en los que reciben formación. A su vez, la base proporciona información individual y de los centros en forma de índices sintéticos, elaborados por expertos de la OCDE basados en la agrupación de preguntas relacionadas realizadas a los alumnos y directores de los centros. La ventaja de trabajar con estos índices es que han sido construidos teniendo en cuenta tanto consideraciones teóricas como estudios empíricos y, a su vez, han sido ampliamente testeados a nivel internacional (OECDa).

Para llevar a cabo el análisis DEA es necesario que las unidades evaluadas sean lo más homogéneas posible dado que, para estimar la frontera productiva y los índices de eficiencia, se asume que todas las unidades evaluadas operan bajo la misma tecnología productiva y, por tanto, bajo el mismo contexto y circunstancias que determinan dicha tecnología. De este modo, cualquier cambio legal, organizativo o curricular que afecte a todos los centros públicos representa un cambio tecnológico que afecta a todas las unidades y que afectaría a la productividad del sector público en su conjunto, pero no al nivel de eficiencia de cada una de las unidades.

El ciclo PISA 2012 es el cuarto en el que participa Uruguay (lo hace desde 2003) en el cual se evaluaron 5.315 alumnos que asistían a 180 centros de enseñaza públicos y privados. En primer lugar, se elimaron del análisis los liceos privados. En segundo lugar, se eliminaron aquellos liceos en los cuales solamente se impartían cursos de Ciclo Básico o de Bachillerato. La edad de corte entre ambos ciclos en Uruguay es justamente a los 15 años y, dado que PISA muestrea alumnos de esta edad, resulta que los alumnos evaluados que asisten a centros donde sólo se imparte Ciclo Básico son inevitablemente repetidores de al menos un curso y, por el contrario, aquellos alumnos de 15 años evaluados en PISA que asisten a liceos donde sólo se imparte Bachillerato, no pueden haber sido repetidores previamente. Como resultado, en los liceos donde sólo se imparte Ciclo Básico, el 100% de los alumnos evaluados en PISA resultan repetidores en al menos un curso previo y, en los liceos donde sólo se imparte Bachilerato, el 100% se encuentra en el curso correcto. Por tanto, estos centros no resultan comparables entre sí a la hora de estimar la frontera productiva.

Esta depuración basada en los ciclos de enseñanza impartidos implica la eliminación del análisis de casi la totalidad de liceos públicos ubicados en Montevideo,6 ya que es allí donde se localizan los liceos que imparten sólo un ciclo educativo. En el Interior del país, por el contrario, los centros educativos imparten ambos ciclos. En suma, el presente análisis se lleva a cabo para 71 liceos públicos mixtos (que imparten ambos ciclos de enseñanza secundaria) del Interior del país.7 Por tanto, este artículo debe interpretarse como una primera aproximación al problema de la eficiencia educativa en los liceos públicos y sería interesante en un futuro tener en cuenta este problema en el diseño muestral de PISA para así disponer de información comparable para todo el país.

Outputs, inputs y variables explicativas de la eficiencia

La medición empírica de la educación recibida por un individuo es muy difícil de cuantificar, sobre todo cuando se desea analizar la calidad de la misma más allá de computar los años de estudio. Sin embargo, existe consenso en la literatura acerca de considerar como outputs educativos los resultados que surjan de pruebas objetivas, ya que son difíciles de falsificar y, sobre todo, son tomados en cuenta por padres y políticos al momento de evaluar el producto educativo para la toma de decisiones (Hoxby). En efecto, Hanushek (1986) observa que dos tercios de los estudios utilizan los resultados en las pruebas como medida de los outputs educativos. En el presente artículo, las variables seleccionadas como outputs del proceso educativo fueron dos: resultado de lectura y de matemáticas.8

En relación a los inputs del proceso educativo, se seleccionaron tres variables teniendo en cuenta la función de producción educativa presentada anteriormente (Ecuación 1) y que a su vez representan los insumos mínimos necesarios para llevar a cabo el proceso de aprendizaje (materia prima, capital físico y capital humano). Asimismo, se priorizó la parsimonia del modelo, con el fin de mantener un buen nivel de discriminación del mismo.

· ESCS (Economic, Social and Cultural Status). Es un índice elaborado por los analistas del proyecto PISA que refleja el status socioeconómico del alumno, y por tanto representa la “materia prima” a transformar en el proceso de aprendizaje. El mismo se deriva de aplicar un Análisis de Componentes Principales Categóricos a tres variables:9 status ocupacional más elevado de cualquiera de los dos padres (HISEI), nivel educativo más elevado de cualquiera de los padres medido en años de educación (PARED), y por último, un índice de posesiones en el hogar (HOMEPOS).10

· SCMATEBUI (School Quality of Physicals’ Infrastructure): es un indicador que refleja la calidad de la infraestructura del centro de enseñanza y que representa por tanto el capital físico disponible. El mismo se elabora en base a la respuesta de los directores sobre posibles factores que dificultan la enseñanza en su centro educativo que incluyen: i) la inadecuación de los edificios escolares; ii) la falta o la insuficiencia de sistemas de calefacción-refrigeración y de iluminación, y iii) la falta o insuficiencia de espacio educativo (por ejemplo, aulas). Las respuestas fueron rescaldadas, de forma tal que a mayor valor del índice, mejor calidad de la infraestructura del centro.

· PROPCERT (Proportion of Fully Certified Teachers). Es un índice que refleja la calidad de los profesores y, por tanto, del capital humano del centro educativo. El mismo resulta de dividir el número total de profesores con título habilitante para la docencia11 por el total de profesores del centro educativo. Esta variable es especialmente relevante para el caso de Uruguay ya que no todos los docentes cuentan con una formación homogénea para impartir las clases en educación secundaria.

Uno de los supuestos básicos del modelo DEA para su correcta especificación es el cumplimiento de la hipótesis de monotonicidad de los inputs (a más input, más o igual output). La Tabla I presenta las correlaciones bivariadas de los outputs e inputs seleccionados, donde se verifica que todas las correlaciones son positivas.

En base a la evidencia internacional previa se seleccionaron doce variables asociadas a los alumnos, y principalmente, al centro educativo que podrían afectar al nivel de eficiencia estimada de los centros educativos.

En cuanto a las variables relacionadas con las características del alumnado se seleccionaron tres variables:

· Porcentaje de alumnos evaluados en el centro que han repetido al menos un curso académico previamente (PCT_repetidores). Esta variable es reflejo de la política de repetición del sistema educativo, y es actualmente uno de los focos de atención del debate nacional. La evidencia internacional muestra que la repetición tiene un efecto negativo sobre los resultados académicos de los estudiantes y, por tanto, se espera a priori un efecto negativo sobre la eficiencia educativa.

· Porcentaje de alumnas en el centro educativo evaluado (PCT_mujeres). La evidencia internacional al respecto no es concluyente en cuanto a este punto (depende de la disciplina que se evalúe) y por tanto se busca indagar si en Uruguay dicha variable afecta la eficiencia de los centros.

· Índice de ansiedad ante la resolución de problemas de matemáticas (ANXMAT) elaborado por los analistas de PISA que surge de la respuesta de los alumnos. La ansiedad ante las matemáticas es una aprehensión por la disciplina que impide el desempeño en matemáticas, independientemente de las habilidades cognitivas reales (Richardson y Suinn) y por tanto es de esperar a priori que impacte negativamente en el grado de aprovechamiento de los estudios de los alumnos.

En cuanto a las variables asociadas a los centros educativos, se incluyen cuatro variables que caracterizan el tipo de centro educativo, la localización y el tamaño de los mismos. La evidencia disponible en Uruguay muestra que estas variables están furtemente asociadas al nivel de resultados de los centros educativos (ANEP). Así, por ejemplo, los liceos presentan mejores resultados que las Escuelas Técnicas, los centros ubicados en localidades muy pequeñas revelan peores resultados que los ubicados en ciudades grandes así como los centros de mayor tamaño muestran mejores resultados. Sin embargo, estos centros con mejores resultados también presentan mejor nivel de recursos educativos. Por tanto, incluir estos aspectos a la hora de explicar ineficiencias nos permite saber si los mejores resultados responden a una mejor gestión de los recursos educativos o simplemente a una mayor dotación inicial de los mismos.

· Variable dicotómica que toma valor uno si el centro educativo es un liceo y cero si es una Escuela Técnica (LICEO).

· Variable dicotómica que toma valor uno si el centro educativo está ubicado en una localidad con menos de 3.000 habitantes (PEQ_LOC).

· Variable dicotómica que toma valor uno si el centro educativo está ubicado en una ciudad de más de 100.000 y menos de 1.000.000 de habitantes.

· Tamaño del centro educativo definido como el total de alumnos que asisten al centro educativo (TAMAÑO).

Por último, en función de la respuesta de los directores, se incorporaron diversas variables que reflejan los métodos de instrucción utilizados por los docentes del centro, la gestión por parte de los directores de los profesores disponibles en los centros y del grado de autonomía percibida por los directores.

· Índice de instrucción directa por parte del profesor (TCHBEHTD) elaborado por los analistas de PISA en base a la respuesta de los alumnos sobre la frecuencia con que el profesor de matemáticas establece objetivos claros para el aprendizaje del estudiante, pide a los estudiantes que presenten sus ideas y razonamientos, hace preguntas para comprobar si los estudiantes entienden lo que se enseña y le dice a los estudiantes lo que tienen que aprender. A mayor valor del índice, mayor nivel de instrucción directa por parte del profesor. A priori se espera que esta variable tenga un impacto positivo en la eficiencia de los centros.

· Índice de escasez de profesores cualificados en el centro educativo (TCSHORT) elaborado por los analistas de PISA en base a las respuestas que los directores proporcionan en cuanto a la percepción de escasez de profesores cualificados de matemáticas, ciencias, lectura u otras asignaturas. A mayor valor del índice, mayor escasez de profesores percibida por el director.

· Variable dicotómica que toma valor uno cuando el director tiene una responsabilidad considerable en decidir sobre las asignaciones del presupuesto del centro educativo (ASIGPRESDIR).

· Variable dicotómica que toma valor uno cuando el director tiene una responsabilidad considerable en establecer las políticas de disciplina para los estudiantes del centro educativo (DISCDIR).

· Variable dicotómica que toma valor uno cuando el director tiene una responsabilidad considerable en establecer las políticas de evaluación de los estudiantes (EVALDIR).

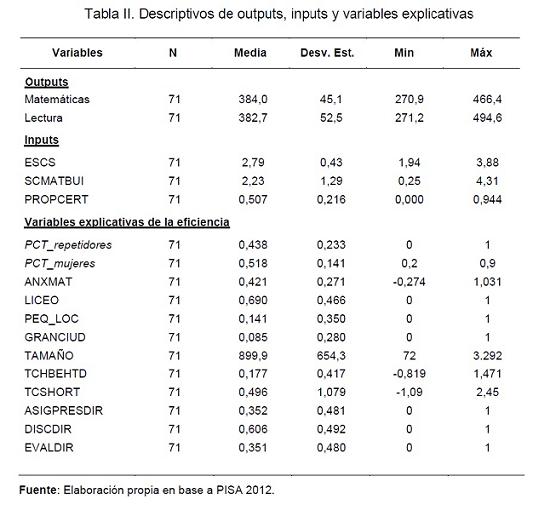

En la Tabla II se presentan los principales estadísticos descriptivos de los outputs, inputs y variables explicativas seleccionados.

RESULTADOS

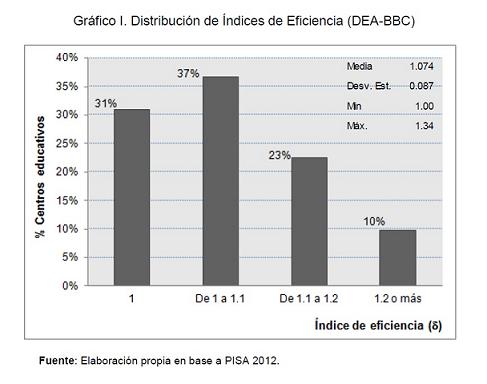

El gráfico I muestra la distribución de los índices de eficiencia,, estimados por el modelo DEA-BCC orientado al output. Los resultados muestran que el 31% de los centros educativos se comportan de manera eficiente y que los resultados educativos podrían aumentar en promedio en un 7,4% teniendo en cuenta los recursos disponibles. Asimismo, uno de cada diez centros educativos podría mejorar sus resultados en más del 20% si fuera eficiente, mientras que casi una cuarta parte de los centros evaluados podrían mejorar los resultados entre un 10% y 20% dados sus inputs actuales.

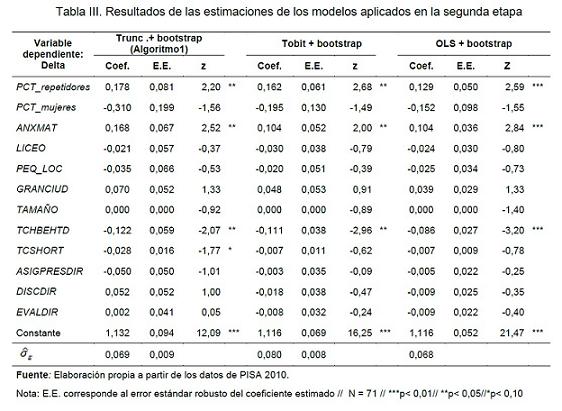

La Tabla III presenta los resultados de la segunda etapa, donde los índices de eficiencia estimados se regresan sobre las variables contextuales. A partir del análisis comparativo de los tres modelos especificados, se puede concluir que no existen grandes discrepancias entre los resultados. El signo, la magnitud y el significado de casi todas las variables son similares en todos los modelos, lo que implica que cualquier recomendación de política educativa derivadas de ellos serían equivalentes añadiendo robustez a los resultados. Teniendo en cuenta esta conclusión general, consideraremos la especificación propuesta por Simar y Wilson como línea de base para la discusión de los resultados.

En primer lugar, existe un conjunto de variables que no afectan a los índices de eficiencia. La primera de ellas es el porcentaje de alumnas mujeres en el centro, lo que indica que la composición según género en el centro educativo no afecta a la eficiencia del mismo. En segundo lugar, el tamaño de la localidad donde está ubicado el centro educativo tampoco parece afectar a la eficiencia del mismo. En promedio, en el caso uruguayo, los centros ubicados en grandes ciudades obtienen mejores resultados educativos que los ubicados en localidades pequeñas o zonas rurales. El hecho de que la localidad no afecte a la eficiencia de forma significativa implica que este mayor resultado responde a una mayor dotación de recursos educativos y no a una mejor gestión de los mismos. En este mismo sentido, la variable que indica si el centro educativo es un liceo o una Escuela Técnica tampoco muestra efectos significativos. Nuevamente, al igual que en el caso de la localidad, los liceos públicos uruguayos presentan en promedio mejores resultados medios que las Escuelas Técnicas. Los resultados de este artículo evidencian que esos mejores resultados se obtienen debido a una mayor dotación inicial de insumos y no al mejor aprovechamiento de los mismos. Por otra parte, la escala de producción representada por el tamaño del centro educativo tampoco parece afectar a la eficiencia de las unidades productivas, ya que los centros de mayor tamaño que presentan mejores resultados académicos en media, también presentan mayor dotación media de inputs educativos. Por último, ninguna de las tres variables asociadas a la autonomía percibida de los directores en los centros resulta significativa. La descentralización de la decisión de asignación de presupuesto o el diseño de las políticas disciplinarias y de evaluación no afectan a la eficiencia de los centros. Este es un aspecto relevante, ya que la descentralización es uno de los focos más intensos del debate educativo actual. La evidencia internacional muestra que la descentralización es exitosa en aquellos países donde también existe un proceso de rendición de cuentas por parte de los centros educativos adecuadamente regulado y con criterios homogéneos (Hanushek et al. 2013; OECD 2013b). Este no es el caso de Uruguay, donde existe gran heterogeneidad en las rendiciones de cuentas y donde, en muchos casos, siquiera existe una forma sistemática de presentarlas. Por tanto, el resultado del presente artículo podría asociarse con la evidencia internacional, lo cual señalaría que descentralizar sólo tendría efectos positivos sobre la mejora de los resultados académicos si se llevara a cabo acompañada de un proceso de rendición de cuentas adecuado. Otra posible interpretación de este resultado radica en el hecho de que las variables surgen de la respuesta y percepción de autonomía de los directores y, por tanto, podría no estar reflejando el verdadero grado de autonomía que éstos tienen. En Uruguay los liceos públicos en general poseen escaso nivel de autonomía en general y, sin embargo, las variables incluidas en el análisis poseen cierto grado de varianza (Tabla II), lo cual podría interpretarse como que existe cierto nivel de distorsión entre la realidad y la percepción de los directores respecto a su responsabilidad y autonomía.

Por el contrario, hay un grupo de variables asociadas a los estudiantes y a las prácticas de enseñanza de los profesores que sí son significativas y con el signo esperado. En primer lugar, el porcentaje de estudiantes repetidores parece ser un factor negativo y significativo de la eficiencia. Este resultado pone en tela de juicio la adecuación de las políticas de retención de grado actuales en Uruguay en todos los niveles del sistema educativo. Uruguay tiene una de las tasas de repetición más altas de la región, lo que contrasta con los resultados de las pruebas internacionales que muestran que este país es uno de los mejores de la región. Por lo tanto, tal vez sería más adecuado identificar en edades tempranas (educación primaria) a aquellos estudiantes que tienen mayor riesgo de repetición y brindarles apoyo adicional desde el inicio con el fin de evitar que efectivamente repitan el curso.

En segundo lugar, otra variable asociada a los alumnos que tiene un efecto negativo y significativo sobre la eficiencia educativa de los centros es el grado de ansiedad de los estudiantes ante las matemáticas (ANXMAT). Este resultado es muy relevante a la hora de pensar en las prácticas educativas a promover, ya que existe evidencia internacional que sostiene que este comportamiento puede ser inducido por las actitudes y expectativas de los profesores y de los padres (Zaslavsky). Por tanto, si se quiere incrementar la eficiencia y mejorar los resultados académicos, se debería trabajar en reducir la ansiedad de los estudiantes a la hora de resolver problemas de matemáticas (y de otras disciplinas por supuesto) tanto dentro de las aulas como en los hogares mediante tareas domiciliarias, lo cual implica, a su vez, fomentar mayor compromiso por parte de las familias para brindar apoyo a los estudiantes. Si bien este artículo se realiza para la educación secundaria, este tipo de prácticas deberían fomentarse desde los inicios de la vida académica de los estudiantes en ciclos anteriores, que es cuando más pueden ser afectadas sus habilidades no cognitivas (Heckman y Kautz).

En tercer lugar, la variable que indica el grado de instrucción directa por parte de los profesores a los estudiantes (TCHBEHTD) muestra un efecto positivo y significativo sobre la eficiencia de los centros educativos. Este índice resume una serie de prácticas y técnicas educativas del profesor que evidencian una fuerte implicancia e interés en el aprendizaje de los alumnos. Establecer objetivos claros en las clases, fomentar el desarrollo y exposición de ideas de los estudiantes, y comprobar frecuentemente que estos entiendan lo que el profesor enseña parecen ser prácticas de enseñanza a fomentar si se quiere mejorar los resultados académicos de los estudiantes a través de una mejora en la eficiencia educativa.

Por último, el grado de escasez de profesores cualificados en el centro percibido por los directores sólo resulta significativo en el modelo propuesto por Simar y Wilson y con un impacto positivo sobre la eficiencia. Este resultado indicaría, por tanto, que en aquellos centros educativos donde los directores perciben mayor escasez de profesores cualificados obtienen mejores resultados (para un nivel de inputs constante), esto es, sacan mayor provecho de sus recursos educativos. Es decir, en ciertos casos no es necesario mayor nivel de profesores cualificados sino mejor aprovechamiento de los mismos. De todas formas, este resultado debe interpretarse con cierta cautela, ya que el grado de escasez es una medida subjetiva percibida por los directores de los centros educativos y, como hemos comentado, puede diferir de lo que efectivamente ocurre en la realidad.

COMENTARIOS FINALES

En la acualidad existe consenso internacional acerca de la necesidad y la importancia de disponer de una población con mayor y mejor nivel de estudios que garantice un crecimiento económico basado en una alta productividad del factor trabajo cualificado. El alto porcentaje de gasto público invertido en educación es un reflejo de esta convicción. Durante la última década, el gobierno uruguayo ha hecho un enorme esfuerzo presupuestario para aumentar los recursos educativos; sin embargo, los resultados académicos no han mejorado. Por el contrario, el sistema de educación público (especialmente la educación secundaria) está en una crisis profunda y el actual debate nacional sobre este problema se centra principalmente en la necesidad de verter más recursos al sistema en lugar de explorar la manera de aprovechar mejor los inputs disponibles, es decir, la forma de lograr un sistema educativo más eficiente. Este es el principal objeto del presente artículo.

Los resultados evidencian la presencia de comportamientos ineficientes en la producción educativa de los centros evaluados, los cuales podrían incrementar en promedio sus resultados en un 7,4% (casi 30 puntos PISA) con la dotación de inputs actual. Asimismo, uno de cada diez centros educativos podría mejorar sus resultados en más del 20% si fuera eficiente, mientras que casi una cuarta parte de los centros evaluados podrían mejorar los resultados entre un 10% y 20% dados sus inputs actuales.

Asimismo, este artículo proporciona conclusiones interesantes desde el punto de vista de la planificación y ejecución de las políticas educativas del sistema educativo. En primer lugar, la ineficiencia es más alta donde hay un mayor porcentaje de estudiantes repetidores. Por lo tanto, sería adecuado revisar las políticas de repetición y brindar apoyo adicional en edades tempranas a aquellos alumnos más vulnerables y con mayor riesgo de repetición. Asimismo, promover técnicas de enseñanza-aprendizaje que reduzcan la ansiedad y mejoren la autoconfianza de los alumnos a la hora de resolver problemas en matemáticas (sobre todo a edades tempranas) permitiría aprovechar mejor los recursos en los centros y obtener así mejoras significativas en los resultados académicos. Por último, también evidencia efectos positivos y significativos sobre la eficiencia educativa la promoción de un mayor nivel de instrucción directa por parte de los profesores en las aulas (establecer objetivos claros en las clases, fomentar el desarrollo y exposición de ideas de los estudiantes, y comprobar frecuentemente que estos entiendan lo que el profesor enseña). Es importante destacar que estos resultados deben interpretarse con cierta cautela. Aunque a priori estas prácticas no generan costos directos adicionales, algunos de ellos podrían llevar asociados costos indirectos para algunos individuos intervinientes en el proceso educativo. Por lo tanto, es imprescindible un compromiso por parte de todos los actores involucrados en el proceso educativo (autoridades, profesores, familias y sociedad) para asegurar una mejora efectiva de la eficiencia educativa.

En suma, el presente artículo ofrece una nueva perspectiva sobre la forma de abordar el problema de la educación actual en Uruguay desde el punto de vista de la eficiencia explorando algunas de las prácticas y políticas que pueden afectar positivamente a los resultados académicos. En este sentido, los resultados del presente artículo deben interpretarse como una primera aproximación y, por tanto, más investigación es, por supuesto, necesaria en esta dirección. Disponer de bases de datos a nivel nacional adecuadas a la realidad uruguaya parece ser el primer paso lógico para poder ampliar el alcance de este artículo tanto geográficamente como para otros ciclos del sistema educativo.

REFERENCIAS

Administración Nacional de Educación Pública (ANEP). Observatorio de la Educación. Disponible en http://www3.anep.edu.uy/observatorio/paginas/matricula/matricula_edsecundaria.html [Accedido en agosto de 2014].

Afonso, Antonio, Ludger Schuknecht y Vito Tanzi. "Public sector efficiency: an international comparison" en Public Choice vol.123, n.3, 2005, pp.321-47.

Afonso, Antonio y Aubyn, Miguel. "Cross-Country Efficiency of Secondary Education Provision: A Semi-Parametric Analysis with Non-Discretionary Inputs" en Economic Modelling vol. 23, n.3, 2006, pp.476-91.

Alexander, W. Robert J., Alfred A. Haug y Mohammad Jaforullah, Mohammad. "A two-stage double-bootstrap data envelopment analysis of efficiency differences of New Zealand secondary schools" en Journal of Productivity Analysis vol.34, n.2, 2010, pp.99-110.

Banco Central del Uruguay. Estadísticas y Estudios, PIB - Cuentas Nacionales. Disponible en http://www.bcu.gub.uy/Estadisticas-e-Indicadores/Cuentas%20Nacionales/presentacion05.htm [Accedido en agosto de 2014].

Banker, Rajiv. D., Abraham Charnes y William W. Cooper. "Some models for estimating technical and scale inefficiencies in data envelopment analysis" en Management Science vol.30, n.9, 1984, pp. 1078-92.

Banker,Rajiv y Natarajan, Ram "Evaluating Contextual Variables Affecting Productivity Using Data Envelopment Analysis" en Operations Research vol.56, n.1, 2008, pp.48-58.

Barro, Robert J., y Jong-Wha Lee. "A new data set of educational attainment in the world, 1950–2010" en Journal of Development Economics vol.104, 2012, pp.184-98.

Battese, George Edward Tim J. Coelli. "Prediction of firm-level technical efficiencies with a generalized frontier production function and panel data" en Journal of Econometrics vol. 38, n.3, 1988, pp 387-99.

---. "Frontier production functions, technical efficiency and panel data: with application to paddy farmers in India" en Journal of Productivity Analysis vol.3, n.1-2, 1992, pp.153-69.

---. "A model for technical inefficiency effects in a stochastic frontier production function for panel data" en Empirical Economics, vol.20, n.2, 1995, pp. 325-32.

Cordero-Ferrera, José Manuel, Francisco Pedraja-Chaparro y Javier Salinas-Jiménez. "Measuring efficiency in education: an analysis of different approaches for incorporating non-discretionary inputs" en Applied Economics, vol.40, n.10, 2008, pp.1323-39.

Cordero Ferrera, José Manuel, Eva Crespo-Cebada y Daniel Santín. "Factors affecting educational attainment: evidence from Spanish PISA 2006 Results" en Regional and Sectoral Economic Studies, vol.10, n.3, 2010, pp.55-76.

Charnes, Abraham, William W. Cooper, Airs Lewin y Lawrence M. Seiford. "Data envelopment analysis theory, methodology and applications en Journal of the Operational Research Society, vol.48 n.3,1997, pp.332-33.

Charnes, Abraham, William W. Cooper y Edwardo Rhodes. "Measuring the efficiency of decision making units" en European Journal of Operational Research, vol.2 n.6, 1978, pp.429-44.

---. "Evaluating program and managerial efficiency: an application of data envelopment analysis to program follow through" en Management Science vol.27, n.6, 1981, pp.668-97.

De Justo, Jorge y Daniel Santín. "Determinantes de la eficiencia educativa en la Unión Europea en Hacienda pública española vol.193, 2010, pp.131-55.

Farrell, Michael J. "The measurement of productive efficiency" en Journal of the Royal Statistical Society, Series A (General) vol.120, n.3, 1957, pp.253-90.

Grosskopf, Shawna, Kathty J. Hayes, Lori Taylor y William L. Weber. William. "Budget-constrained frontier measures of fiscal equality and efficiency in schooling" en Review of Economics and Statistics vol.79, n.1, 1997, pp. 116-24.

Hanushek, Eric A. "A Conceptual and empirical issues in the estimation of educational production functions" en Journal of Human Resources, 1979, pp.351-88.

---. "The economics of schooling: Production and efficiency in public schools" en Journal of Economic Literature vol.24, n.3, 1986, pp.1141-77.

---. "The Failure of Input-based Schooling Policies" en The Economic Journal vol.113, n.485, 2003, pp.64-98.

Hanushek, Eric. A., Susanne Link y Ludger Woessmann. "Does school autonomy make sense everywhere? Panel estimates from PISA" en Journal of Development Economics vol.104, 2013, pp.212-32.

Hanushek, Eric. A. y Ludger Woessmann. "Do better schools lead to more growth? Cognitive skills, economic outcomes, and causation" en Journal of Economic Growth vol.17, n.4, 2012, pp.267-321.

Hoff, Ayoe. "Second stage DEA: Comparison of approaches for modelling the DEA score" en European Journal of Operational Research vol.181 n.1, 2007, pp.425-35.

Hoxby, Caroline M. "The productivity of schools and other local public goods producers" en Journal of Public Economics vol.74, n.1, 1999, pp.1-30.

Levin, Henry M. "Measuring efficiency in educational production" en Public Finance Quarterly vol.2, n.1, 1974, pp.3-24.

Mancebon, María Jesús y C. Mar Molinero. "Performance in primary schools" en Journal of the Operational Research Society vol.51, n.7, 2000, pp.843-54.

McCarty, Therese A. y Suthathip Yaisawarng. "Technical efficiency in New Jersey school districts" en Fried, Harold, C. A. Knox Lovell y Shelton S. Smith (eds.) The measurement of productive efficiency: Techniques and applications. New York: Oxford University Press, 1993.

McDonald, John. "Using least squares and tobit in second stage DEA efficiency analyses" en European Journal of Operational Research vol.197, n.2, 2009, pp.792-98.

OECD - PISA 2012. Assessment and Analytical Framework: Mathematics, Reading, Science, Problem Solving and Financial Literacy. OECD Publishing, 2013a.

OECD - PISA 2012 Results: What Makes Schools Successful? Resources, Policies and Practices (Volume IV) OECD Publishing, 2013b.

Ray, Subhash C. "Resource-use efficiency in public schools: A study of Connecticut data" en Management Science vol.37, n.12, 1991, pp.1620-28.

Richardson, Frank C. y Ricjard M. Suinn. "The Mathematics Anxiety Rating Scale: Psychometric Data" en Journal of Counseling Psychology vol.19, n.6, 1972.

Simar, Leopold y Paul Wilson. "Estimation and inference in two-stage, semi-parametric models of production processes" en Journal of Econometrics vol.136, n.1, 2007, pp.31-64.

Worthington, Andrew C. "An empirical survey of frontier efficiency measurement techniques in education" en Education Economics vol.9, n.3, 2001, pp. 245-68.

Xue, Mei y Patrick T. Harker. "Overcoming the inherent dependency of DEA efficiency scores: a bootstrap approach" en Working Paper, Wharton Financial Institutions Center, University of Pennsylvania, 1999.

Zaslavsky, Claudia. Fear of Math: How to Get over It and Get on with Your Life. New Jersey: Rutgers University Press, 1994.

1 Candidata a Doctor en Economía por la Universidad Complutense de Madrid (UCM), Máster en Economía con especialidad en Economía Pública en la UCM y Licenciada en Economía por la Universidad de la República (UdelaR). Es docente del departamento de Métodos Matemáticos Cuantitativos de la FCEyA (UdelaR) e Investigadora Asociada del Sistema Nacional de Investigadores (SNI).

2 En el mismo período el PIB experimentó un incremento acumulado en términos reales de 33% (Banco Central del Uruguay).

4 También es posible estimar la frontera orientada a los inputs, donde se minimiza la cantidad de recursos dado un nivel de output y tecnología disponibles. En el presente artículo, se ha optado por el modelo orientado al output dado que, en muchos casos, los inputs no son controlables por los centros educativos y, a su vez, el objetivo se centra en mejorar los resultados obtenidos actualmente y no en reducir recursos.

5 El primero se conoce como Modelo CCR y el segundo como Modelo BBC por las iniciales de sus autores.

6 Sólo dos centros evaluados en PISA 2012 en Montevideo imparten ambos ciclos, y para mantener una consistencia en el análisis fueron eliminados y sólo se analizan los centros ubicados en el Interior.

7 En 2012, el 75% de los centros de enseñanza secundaria públicos se ubican en el Interior del país (ANEP).

8 No ha sido considerado el resultado medio en Ciencias, dado que aporta escasa información adicional a los resultados en lectura y matemáticas. El modelo DEA pierde capacidad de discriminación a medida que se incrementan las dimensiones del problema y por tanto se priorizó la parsimonia del modelo seleccionando sólo dos outputs.

9 Tanto el índice ESCS como las variables que lo componen están estandarizados, con media correspondiente a los países miembros de la OCDE igual a cero y desviación estándar igual a 1.

11Título habilitante para la docencia expedido por ANEP o una institución privada habilitante.