Introducción

La atención inicial en el servicio de urgencia hospitalario (SUH) y la percepción del paciente en su acceso mismo dependen en gran parte de la valoración efectuada en el triaje1, que no solo contempla la clasificación, sino que incluye otros aspectos como la información y ubicación en el servicio2. Esta función puede ser realizada por diferentes recursos humanos: médicos, enfermeros y estudiantes de Medicina. Contar con un sistema de triaje es considerado un indicador de calidad de riesgo-eficiencia para los servicios de urgencias hospitalarios y un instrumento para elaborar casuística (figura 1)3,4.

La Organización Panamericana de la Salud (OPS) recomendó la utilización de un sistema de triaje en todos los centros que tienen un servicio de urgencia para primer, segundo y tercer nivel de atención. Recomienda, además, la utilización de un sistema estandarizado compuesto de cinco niveles de prioridad en la atención, que funcione las 24 horas del día, que tenga un lenguaje común, que sea sistematizado e informatizado y que se adapte a la realidad de cada centro asistencial, teniendo en cuenta los tipos de consultas y la disponibilidad de recursos2,5,6).

Ante las importantes ventajas que aportaría un programa de ayuda a la decisión en el triaje, basado en una escala de triaje moderna y validada, desarrollamos nuestro programa informático de ayuda al triaje basado en el sistema de triaje Manchester5. Para despejar posibles dudas sobre la conformidad del programa y con la finalidad mejorar su versión, realizamos un estudio piloto para evaluar el grado de concordancia interobservador del programa respecto al triaje realizado por profesionales expertos y no expertos.

Se plantearon como objetivos demostrar la clasificación efectuada por personal entrenado previamente (experto) y no experto, y su concordancia con el sistema informatizado.

Material y método

En primera instancia se realizó un curso de inducción de clasificación por prioridades asistenciales (triaje) desarrollado por la cátedra del Departamento de Emergencia del Hospital de Clínicas. El mismo tuvo como personal objetivo 17 personas del área de la salud (tres médicos, dos practicantes internos de medicina, ocho auxiliares de enfermería y cuatro licenciados en enfermería) seleccionadas por la autoridad local del hospital solicitante del curso, y que pertenecían a diferentes salas de urgencia y emergencia de centros de asistenciales de primer, segundo y tercer nivel de atención de los departamentos de Paysandú y Artigas, y a quienes consideramos como no expertos por no trabajar previamente con un sistema de triaje normatizado y estructurado. Las personas elegidas participaron activamente en la clasificación de los pacientes que consultan en las puertas de emergencia de primer, segundo y tercer nivel de centros de Paysandú y Artigas, aún sin tener acceso a un sistema informatizado y automatizado como apoyo, ni una capacitación mayor en el tema, sabiendo que en el Hospital de Paysandú se reciben un promedio de 100 consultas diarias, y algunas menos en el Hospital de Artigas. El fundamento de elegir un grupo de no expertos se basa, además, en la posibilidad de extender el sistema a operadores no expertos. La elección de la muestra incluye a los participantes de la jornada de triaje en Paysandú, se trata entonces de una muestra de conveniencia. Al mismo tiempo, acordamos que por lo acotado de la muestra las conclusiones tendrán limitación en cuanto a los resultados. De todas formas este estudio piloto tiene el objetivo de analizar la concordancia del método y plantear sugerencias para un estudio de mayor tamaño y diseñado a tales efectos. En este estudio piloto definimos no experto al individuo que no conoce el funcionamiento del sistema de triaje y que recibe un entrenamiento muy breve antes de realizar el triaje de pacientes que se presentó en este trabajo.

Las actividades fueron realizadas los días 27 y 28 de abril de 2017. El curso de inducción consistió en un curso teórico del tema (cuatro horas de duración), para posteriormente invitar a cada uno de los participantes a realizar un ejercicio de clasificación de pacientes en forma de taller, sin soporte informático. El curso teórico abarcó nociones de gestión asistencial de las áreas de emergencia, así como la inducción a la utilización del sistema informatizado. Se presentaron 34 casos iguales a cada uno de los talleristas y se les solicitó que otorgaran un color a cada uno de los casos. Los casos clínicos fueron reales, los pacientes habían consultado en la emergencia del Hospital de Clínicas, pero seleccionados dentro de un conjunto amplio, lo cual determinó efectivamente una selección por conveniencia. No se brindaron datos filiatorios que identificaran a los pacientes. Sí se brindaron los datos habituales utilizados para realizar la clasificación, el síntoma guía (motivo de consulta) y las constantes fisiológicas (factores discriminantes) para cada caso y se solicitó que asignaran un nivel de prioridad a cada uno, según lo aprendido en la exposición teórica asignándole el color correspondiente a la prioridad. Paralelamente, se le solicitó a una persona experta en triaje del Hospital de Clínicas (quien lleva tres años de experiencia, denominada observador 1) que efectuara la clasificación de los 34 casos y sin apoyo informático como el resto del grupo. Finalmente, todos los casos fueron clasificados con el sistema informático automatizado del Hospital de Clínicas.

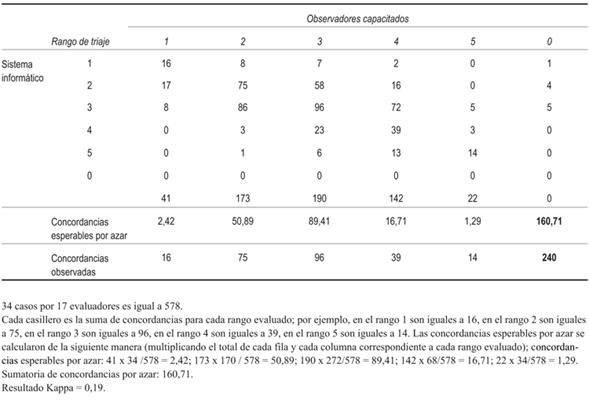

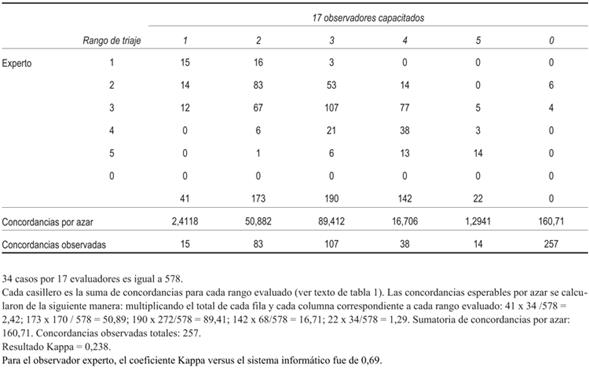

Los resultados fueron llevados a formato de planilla electrónica tipo Excel, para su análisis ulterior. A partir de los datos generados se realizó el cálculo de concordancia a través del coeficiente de concordancia Kappa entre los no expertos, el experto y el sistema informatizado. Se calculó el coeficiente Kappa de la siguiente manera = (Σconcordancias observadas - Σconcordancias por azar) / (número de observaciones - Σ concordancias por azar).

En cuanto a la elección de un valor de corte Kappa, de acuerdo a la literatura previa se menciona que los Kappa son más altos cuando los códigos son equiprobables. Del mismo modo, el efecto del sesgo es mayor cuando Kappa es más pequeño. A medida que aumenta el número de códigos, los Kappa se vuelven más altos. De acuerdo con Bakeman, “ningún valor de Kappa puede considerarse universalmente aceptable”. Considerando lo anterior, se han definido escalas numéricas para el Kappa, por ejemplo, Landis y Koch caracterizaron los valores <0 como indicativos de no acuerdo y 0-0,20 como leves, 0,21-0,40 como regular, 0,41-0,60 como moderado, 0,61-0,80 como sustanciales y 0,81-1 como casi perfecto7-10). Fleiss caracteriza a Kappa de acuerdo con la siguiente escala: por encima de 0,75 como excelentes; 0,40 a 0,75 como regulares a buenos, y por debajo de 0,40 como pobres. Nosotros tomamos arbitrariamente la clasificación de Fleiss.

Resultados

Se obtuvieron un total de 578 clasificaciones (17 no expertos realizaron 34 casos cada uno) cuyos resultados fueron llevados a formato de planilla electrónica tipo Excel, para su análisis ulterior. A partir de los datos generados se realizó el cálculo de concordancia a través del coeficiente Kappa entre los no expertos, el experto y el sistema informatizado (tabla 1, relación entre índice Kappa y fuerza de concordancia). En la comparación de concordancias entre cada observador respecto al sistema de triaje informatizado, se encontró que el observador no experto con más resultados iguales obtuvo 53% de acuerdo con el sistema informatizado de triaje (18 concordantes de 34); entre los no expertos, el que obtuvo menos resultados iguales tuvo 32 % de similitud (11 concordantes de 34). En el grupo de no expertos el promedio global de concordancia fue de 41%. Por otro lado, al comparar las respuestas del observador experto con el sistema se observó 79 % (27/34) de resultados iguales respecto al sistema informatizado de triaje. En la (tabla 1) se muestran los resultados de concordancia para cada observador no entrenado en cada categoría de triaje versus el sistema informático, la concordancia evaluada con Kappa fue de 0,19. En la (tabla 2) se muestran los resultados de acuerdo en cada categoría con el observador experto, la concordancia evaluada con Kappa fue de 0,23. El observador experto versus el sistema informatizado tuvo un índice Kappa de 0,695; mientras que los observadores capacitados, comparados con el sistema informatizado y el observador experto, obtuvieron un índice Kappa de 0,19 y de 0,238, respectivamente.

Discusión

Nuestro trabajo muestra un buen nivel de concordancia si comparamos un clasificador experto versus el sistema informatizado de triaje del Hospital de Clínicas. En cambio, no se pudo comprobar la misma concordancia cuando la comparación se realizó con observadores capacitados con cuatro horas de capacitación; la concordancia fue débil entre este grupo capacitado versus un observador experto o el propio sistema informático. El observador experto tiene un nivel de concordancia superior en relación con los observadores capacitados cuando se compara con el sistema informatizado automatizado. En cambio, no se pudo comprobar la misma concordancia cuando la comparación se realizó con observadores con cuatro horas de capacitación; la concordancia fue débil entre este grupo capacitado versus un observador experto o el propio sistema informático. Se plantea que una sesión breve de capacitación no logra una concordancia adecuada con el observador experto y con el sistema informático.

En definitiva, es la utilización de la informática automatizada en el triaje como medio de estandarización y como defensa frente a la dispersión por la aleatoriedad vinculada al factor individual y administrativo. Sin embargo, aún faltan trabajos nacionales de validación para nuestro sistema, lo cual representa un factor de dispersión.

Nuestro estudio tiene varias debilidades. En primer lugar, existe un claro sesgo de selección de observadores, lo que no permite extender este trabajo a conclusiones ulteriores. Es un estudio piloto que no permite elaborar conclusiones definitivas. En segundo lugar, se incluyen observadores con diferente entrenamiento y formación en la muestra, ya que en el grupo de 17 observadores existen médicos y enfermeros. Por otro lado, no realizamos comparaciones de los niveles de concordancia con otro estándar porque no fue el objetivo. El error aleatorio es elevado dado que el tamaño de la muestra es pequeño y no hay controles de variabilidad, por ejemplo estratificar por entrenamiento o profesión de los 17 participantes. El programa de entrenamiento que se usó para capacitar a los 17 participantes no fue evaluado previamente para determinar si era necesario un mayor período de tiempo de entrenamiento. No hay trabajos que determinen cuál es el tiempo de capacitación adecuada para considerar que el personal se encuentra entrenado.

La selección del personal no fue basada exclusivamente en quienes debieran realizar el triaje, según las recomendaciones internacionales, sino en quienes realmente lo efectivizan en dichos centros, por lo que la capacidad en la captación de la urgencia en la atención, y por lo tanto en la asignación de un nivel de prioridad, puede ser variable entre los distintos participantes.

El curso de entrenamiento que se usó para capacitar a un personal no entrenado se realizó dirigido al personal de salud en forma amplia, incluyendo enfermería.2,11,12

Hasta donde tenemos conocimiento, a pesar de las limitaciones de este trabajo piloto, esta sería la primera publicación realizada en Uruguay sobre triaje en una puerta de emergencia utilizando un sistema nacional informatizado automatizado. Es seguro que se requiere continuar trabajando en ello, existiendo nuevas líneas de investigación en este sentido. Como parte de la tarea de extensión universitaria, la Cátedra y el Departamento de Emergencia del Hospital de Clínicas vienen realizando jornadas de difusión, capacitación y entrenamiento en el proceso de triaje en los centros de salud que así lo soliciten, tanto a nivel público como privado.

Conclusiones

El nivel de concordancia del triaje realizado por un programa informatizado es bueno cuando se lo compara con personal capacitado como experto y entrenado en su realización; sin embargo, la concordancia con el sistema informatizado es menor cuando el personal recibe un entrenamiento de breve duración. Son necesarios estudios de mayor tamaño para confirmar definitivamente estos hallazgos.